【数据中心热效率】Facebook 数据中心的服务器设计

日期:2015-04-09

大型数据中心的配备需要消耗数百万瓦的电力和数亿美元的资金。因此,降低服务器的能耗和成本可能产生重大影响。

由于预期的工作负荷非常大,因此对 Web、网格和云服务器的优化尤其困难。对于在俄勒冈州普赖恩维尔设立的第一个数据中心,Facebook 计划大幅度提高功率效率、成本、可靠性、可服务性,以及改善环境。为此,公司采用整体方法,对数据中心和服务器的许多方面重新进行设计。本文摘录自 Facebook 文章“High-efficiency Server Design”。该文章发布于 2011 年超级计算机 ACM 大会上,重点讨论了上述服务器的设计,并涉及电源、主板、热和机械设计等多个方面。在本文中,我们将单独讨论热方面的内容。在完整版文章中,Facebook 计算并以实验方式证实,其定制设计的服务器不仅可以降低整个载荷范围内的功耗,还可以降低购置和维护成本。该设计没有削弱服务器的性能或可移植性,因而服务器的适用性并未受到限制。重要的是,服务器设计已通过开放计算项目提供给开源社区,后者是一个快速成长的全球工程师社区,其宗旨是设计和交付最高效的服务器、存储和数据中心硬件设计,用于可扩展计算应用。在过去的十年中,个人计算领域发生了根本性的变化。许多现代计算机使用网络与通信、搜索、媒体创建和消费、购物和游戏等各种功能,因此越来越依赖于远程服务器来执行这些功能。

这些应用程序的计算和存储压力在很大程度上已经从个人计算机转移到服务提供商(如 Amazon、Facebook、Google 和 Microsoft 等)的数据中心。因此,这些服务提供商可以提供更高质量和更大规模的服务,例如可以在几分之一秒的时间内几乎搜遍整个互联网。同时,服务提供商也受益于规模经济,提高了服务效率。

作为这些服务提供商之一,Facebook 曾经租用数据中心,并在其中装入商用服务器。由于相对能源成本仍较小并且相对定制成本远远超出潜在的好处,因此这种选择对于中小型规模提供商而言是顺理成章的。但随着 Facebook 网站成长为世界上最大的网站之一,以及计算需求的相应增长,Facebook 开始探寻更高效的服务器和数据中心设计方案。

热设计

服务器热设计的目标是以最少的能源和元器件成本开支将热元器件的温度降至操作温度。用于数据中心级别服务器散热的典型机制是冷却大量空气,并使用内部风扇推动这些空气吹过服务器。冷空气会带走服务器元器件的热量,并从服务器出口吹出,然后释放到大气中,或进行降温和再循环。

更高效的散热方式是使用通道空气隔离的方法,使服务器前端(或入口)朝向“冷通道”,后端面向“热通道”。还有一种提高散热效率的方法是使用大型数据中心风扇,在通道之间形成空气压差。这种情况下的具体设计目标是冷却即将使用的数据中心。即使入口空气温度和湿度相对较高,也能有效地冷却服务器,而无需全年冷却外部空气。为实现这一目的,需要一套比当前在商用服务器中使用的热传递设计更加有效的设计方案。

在这里,改善通过服务器的气流成为关键因素:当内部服务器元器件阻碍气流时,需要消耗更多的散热能量(例如,使用转速更快的风扇、温度更低的入口空气或更高的气压)。一种可以改善机架内气流的方法是加宽主板,并排安装(而非前后安装)热元器件。通过将最热的元器件 — 处理器和内存 — 安装在比较靠近空气入口的位置而不是典型的背装式主板内,使其最先接触到最冷的空气。

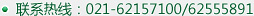

另一个修改的地方是服务器高度:假定机架高度相对不变(出于维修的目的),高度较高的服务器在降低散热能耗的同时,还能降低机架的计算密度。通过计算,我们发现,能够实现最大计算容量与散热能耗比的最佳服务器高度是不常用的 1.5U,同时使用表面积较大的散热器。此高度还允许在主板顶部安装一个通风管,并且精准地引导气流流过并行热轨道上的热元器件,从而降低机架内发生泄漏和空气再循环的可能。这样就能最大限度减少气流受阻的现象,从而减少吹出空气所需的风扇数量(图 1)。

.jpg)

图 1. FloTHERM 热设计的等距视图展示了机架、主板(包含并排安装的双处理器和内存插槽)、风扇和 PSU 后面的硬盘驱动器 (HDD)。

图中的温度范围假定入口温度为 27°C。为便于查看,已省略顶部的通风管。

由于高效率的 PSU 在载荷条件下产生的余热小于 20W,因此即使将硬盘安装在 PSU 后面,它的温度也能保证落在指定的工作温度范围内。与这种设计相比,典型的服务器设计将硬盘安装在机架前部以满足散热要求。此外还减少了保持系统散热所需的气流量 — 在出入口温差相同的情况下,这种设计所需的体积流量可能低至标准 1U 服务器所需体积流量的一半(图 2)。

.png)

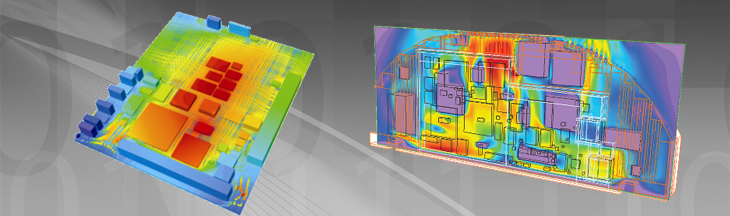

图 2. 风扇最小连续转速时的气流速度 FloTHERM CFD 仿真

较低的气流量要求结合智能风扇转速控制器,可使风扇几乎全年都以最小连续转速运转。不过,这取决于环境温度和工作负荷。

这种低速连续运转的另一个优势是,与典型风扇的启停周期相比,这种设计下的风扇寿命更长,从而改善了服务器的整体可靠性。此外,该设计理所当然还能降低服务器散热带来的功耗和运营成本 — 约为服务器总功耗的 1%;与之形成对比的是,商用服务器的这一比例通常高达 10%。令人有些惊讶的是,即便是服务器散热元器件的 CAPEX 也要比一般服务器约少 40-60%,具体取决于 OEM 元器件价格。实现上述改善的原因主要有两个,即,使用了更薄的风扇(得益于气流量的减少)以及更简单且不带热管的散热器(得益于表面积的扩大)。最后,上述效率提升同样适用于数据中心层面。当进风口温度为 35°C,相对湿度为 90% 时,服务器仍能可靠地工作,而这超过了 ASHRAE 所推荐的最激进的数据中心设备工作值。事实上,这种设计使 Facebook 的数据中心几乎完全依靠自由(外部)空气进行散热,只有在特别炎热的日子才会偶尔使用蒸发散热方法,而不是冷却器。

方法

Facebook 对这种新设计的原型以及两个商用服务器在电源、热和性能属性方面进行了对比评估。两个商用服务器来源于两个主要 OEM,均是常见的现成品,并且配备 1U 标准配置:Xeon X5650 双处理器、12GB DDR3 ECC 内存、板载千兆位以太网、250G SATA 单硬盘。第一个服务器(“商用 A”)广泛部署在 Facebook 主要网络应用程序的租用数据中心。第二个服务器(“商用 B”)是一种已有三年历史的机型。为了能够容纳最新一代处理器,该服务器已进行了更新升级。为确保公平比较,三个服务器轮流使用完全相同的 CPU、内存和硬盘。唯一不同的元器件是机架、主板、风扇和电源 (208V ac/277V ac)。

热效率

热效率是总体拥有成本 (TCO) 的另一个重要因素,对服务器(风扇能耗)散热能耗,抑或是数据中心散热能耗均如此。该热设计基于在 1.5U 间距的敞开式机架上安装的一个未插元器件的平展电路板,并安装了四个定制的 60 x 25mm 高效轴流式风扇。相反,商用服务器使用插满元器件的热遮蔽 1U 机架以及 6 个 40x25mm 现成风扇。为了评估热效率,每个服务器被置于一个专门建造的气流室内。该气流室可分离并测量通过服务器的气流量(单位:立方英尺/分钟,CFM)。通过测量服务器的交流功率和进出口之间的气温差,使用分析方法确认测得的 CFM 值。服务器装载了一个模拟 Facebook 生产功率载荷(约 200W,漏电功率低于 10W)的仿真负载,同时将所有元器件温度均限制在其操作热规格范围以内。原型结果(图 3)表明改善非常明显。对于一个 7.5MW 的典型数据中心而言,气流量减少意味着散热 OPEX 降低约 8-12%。更重要的是,数据中心可以使用自由空气进行散热。

.png)

图 3. 200W 时的气流量比较(单位:CFM)

结论

这种新型服务器设计在不降低性能的前提下,大幅降低了总体拥有成本。该自定义服务器设计可以:

1.降低运行和散热功耗(如高效的功率转换、高品质的功率特性、更少的元器件、更薄和速度更慢的风扇、改善的气流)。

2.降低了购置成本和服务器的重量(如更少且更简单的元器件、更低的密度、更少的扩展选件)。

3.降低了配套基础设施成本(如无集中式 UPS,无 PDU,无冷却器)。

4.提高整体可靠性(如更少且更简单的元器件、分布式冗余电池、平稳的正常/备份转换、硬盘交错启动、速度更慢的风扇)。

5.提高可服务性(如所有前端服务接入、更简便的线缆管理、无多余的塑料或盖)。

从更大层面来看,该设计可带来大量节省。根据 Facebook 的计算,以三年为一个周期,这些服务器的吞吐量至少提高了 19%,成本降低了 10% 左右。与功率预算相同且载满商用服务器的同等数据中心相比,使用该设计建造的数据中心至少要节省几吨原材料。如果与对应的数据中心设计配套使用(包括散热、供电、备用电源和机架设计等所有方面),功率节省将增至 38%,成本节省增至 24%,对应的能源使用效率 (PUE) 约为 1.07。

参考文献:

[1]. Eitan Frachtenberg、All Heydari、Harry Li、Amir Michael、Jacob Na、Avery Nisbet、Pierluigi Sarti,Facebook。“High-Efficiency Server Design”,2011 年

沪公网安备 31010602003953号

沪公网安备 31010602003953号